直播系统开发全攻略:从核心技术到实战优化,打造流畅无延迟的直播体验

直播系统开发正在改变我们获取信息的方式。想象一下,你正在观看一场球赛直播,画面流畅无延迟,仿佛置身现场。这种体验背后是一套复杂的技术体系在支撑。

1.1 什么是直播系统开发?

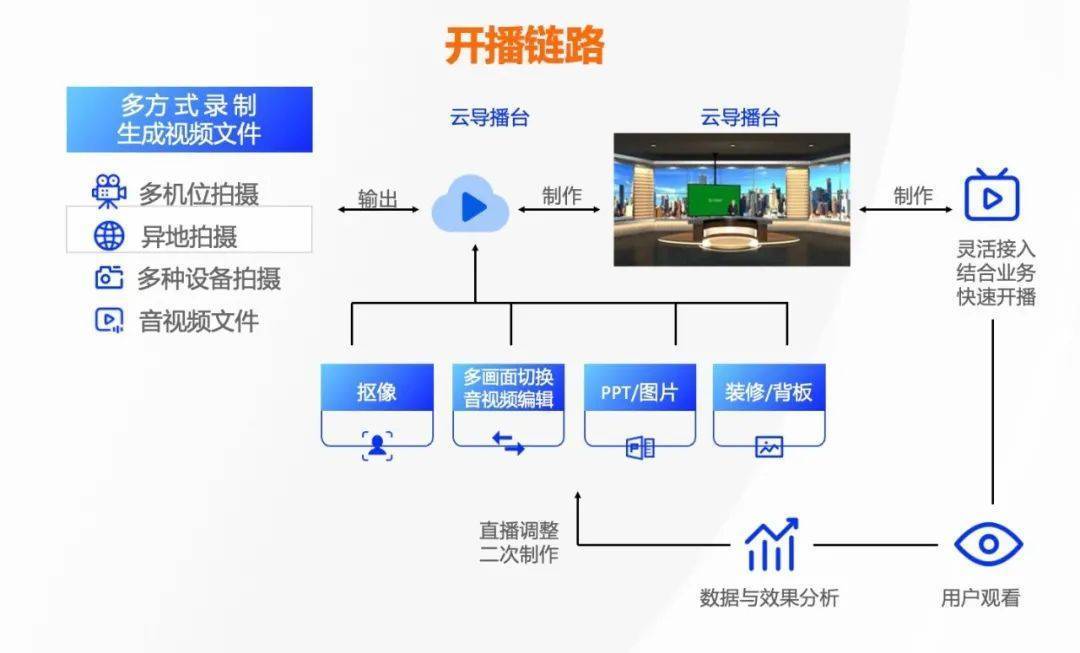

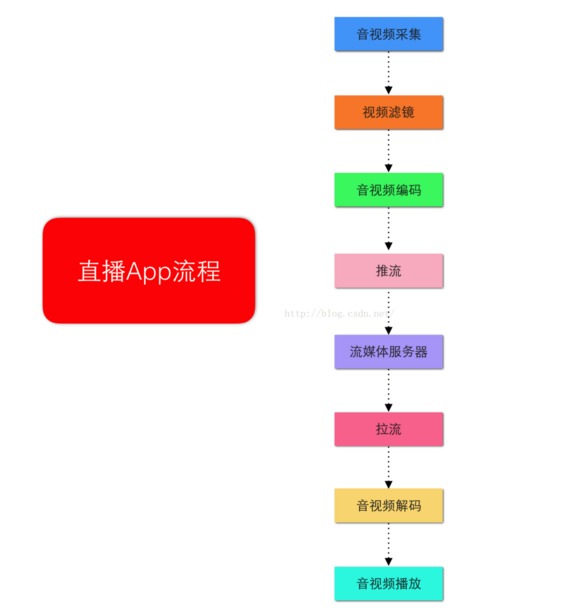

直播系统开发本质上是在构建一个实时内容分发网络。它需要处理从视频采集到最终播放的完整链路。与传统录制视频不同,直播对实时性有着近乎苛刻的要求。

我记得第一次接触直播开发时的困惑。那时我以为只是简单地把摄像头画面传到网上,后来才发现这背后涉及音视频编码、网络传输、内容分发等多个技术领域的深度整合。直播系统开发就是将这些技术组件有机结合起来,确保用户能够实时观看高质量的视频内容。

1.2 直播系统开发的核心技术组件有哪些?

一个完整的直播系统通常包含五个关键组件:

采集端组件 负责音视频信号的捕捉。包括摄像头、麦克风等硬件设备,以及相应的采集软件。这部分需要考虑不同设备的兼容性问题。

编码处理组件 将原始音视频数据压缩编码。H.264/H.265是当前主流的视频编码标准,能在保证质量的同时大幅减小数据体积。

传输分发组件 构建内容分发网络(CDN),将编码后的数据快速分发到各个边缘节点。这个组件的设计直接影响直播的稳定性和覆盖范围。

播放端组件 终端用户的播放器,需要支持多种格式解码和自适应码率切换。优秀的播放器能根据网络状况智能调整画质。

信令控制组件 管理整个直播流程的协调工作,包括房间管理、用户权限、弹幕互动等功能。

这些组件协同工作的方式确实令人赞叹,每个环节都需要精心设计。

1.3 直播系统与传统视频系统的区别是什么?

实时性要求是最明显的差异。直播系统必须在秒级内完成整个处理流程,而点播系统可以有更长的缓冲时间。

数据流向也完全不同。直播是单向推送模式,内容生产者推流,消费者拉流观看。点播系统则是用户主动请求特定内容。

存储方式上,直播通常采用环形缓冲区,旧数据会被新数据覆盖。点播系统需要持久化存储所有内容。

容错机制也有显著差别。直播可以容忍少量数据丢失,因为实时性更重要。点播系统必须确保数据的完整性和准确性。

成本结构方面,直播对带宽要求更高,需要实时分发大量数据。点播可以通过预分发优化带宽使用。

这种差异决定了两种系统在架构设计和优化策略上的不同侧重。直播更关注实时性和稳定性,点播更注重存储效率和点播体验。

构建一个可靠的直播系统就像搭建一座精密的数字桥梁。它需要将实时产生的音视频数据,稳定高效地传递到成千上万的观众面前。这个过程中,技术架构的设计决定了直播体验的上限。

2.1 直播系统开发的技术架构包含哪些层次?

现代直播系统通常采用分层架构设计,这种模块化的思路让系统更易于维护和扩展。

采集层 位于最前端的采集层负责音视频信号的获取。从手机摄像头到专业摄像机,不同设备采集的数据格式各不相同。这个层次需要处理设备兼容性和数据标准化的问题。

处理层 原始音视频数据量巨大,直接传输几乎不可能。处理层通过编码压缩减少数据体积,同时进行美颜、滤镜等实时处理。编码质量直接影响最终观看体验。

传输层 这是直播系统的核心枢纽。传输层负责将处理后的数据推送到边缘节点,并通过CDN网络进行分发。这个层次的设计需要考虑网络波动和负载均衡。

分发层 基于CDN的内容分发网络确保用户能从最近的节点获取数据。优秀的分发层能智能调度流量,避免单点故障。

播放层 终端用户的播放器属于这一层。它需要支持多种解码格式,并能根据网络状况自适应调整码率。

这种分层架构让每个组件都能专注自己的职责。我记得参与过一个项目,最初把所有功能都塞在一个模块里,后来按层次重构后,系统稳定性和开发效率都得到了显著提升。

2.2 如何设计直播系统的推流与拉流方案?

推流和拉流是直播数据流动的两个方向,它们的设计直接影响直播的实时性和稳定性。

推流方案设计 推流端需要平衡质量和流畅度。通常采用RTMP协议进行推流,它能在TCP基础上提供稳定的传输。推流策略上,建议设置多码率自适应,让推流端能根据网络状况动态调整推流质量。

缓冲机制的设计很关键。过小的缓冲区会导致卡顿,过大则会增加延迟。一般来说,设置2-3秒的缓冲区能在流畅性和实时性间取得较好平衡。

拉流方案设计 拉流端支持多种协议很重要。除了传统的FLV、HLS,新兴的WebRTC协议在低延迟场景表现优异。智能调度算法能帮助用户连接到最优的CDN节点。

重试机制必不可少。当拉流中断时,播放器应该能自动重连,并从断点继续播放,而不是让用户手动刷新。

在实际项目中,我们曾测试过不同协议组合。RTMP推流配合HLS拉流在移动端表现稳定,而WebRTC在互动直播场景中延迟控制更出色。

2.3 直播系统开发中的编码与传输协议选择

编码和协议的选择往往需要在效率、兼容性和延迟之间权衡。

视频编码选择 H.264仍然是目前最兼容的选择,几乎所有设备都支持硬解码。它的编码效率已经相当成熟,能在保持不错画质的同时控制码率。

H.265提供了更好的压缩率,相同画质下能节省约50%带宽。但它的编码复杂度更高,对终端设备的解码能力要求也更高。AV1作为新兴编码格式,开源且效率优秀,但生态还在完善中。

音频编码考量 AAC是音频编码的主流选择,在音质和压缩率间取得了很好平衡。Opus编码在低码率下表现更佳,特别适合语音直播场景。

传输协议搭配 RTMP协议成熟稳定,推流场景的首选。它的延迟可以控制在2-3秒,满足大多数直播需求。

HLS协议兼容性极佳,但延迟通常在10秒以上。适合对实时性要求不高的场景。

WebRTC能实现亚秒级延迟,完美契合互动直播需求。不过它的部署复杂度较高,需要额外的信令服务器。

这些技术选型没有绝对的最优解,更多时候需要根据具体业务场景来权衡。一个电商直播可能更看重低延迟,而教育直播可能更关注画质和稳定性。

当观众在弹幕里吐槽“卡成PPT”时,背后往往是延迟和性能问题在作祟。这些问题就像直播系统的隐形杀手,悄无声息地破坏着用户体验。

3.1 直播系统延迟产生的主要原因有哪些?

直播延迟是个复杂的问题,它像多米诺骨牌一样在各个环节累积。

网络传输延迟 数据包在网络中旅行需要时间。从推流端到边缘节点,再到观众端,每一跳都会增加延迟。网络拥塞时,路由器排队等待的时间可能比实际传输时间还长。

编码解码耗时 原始视频数据需要编码压缩,这个过程消耗的时间不容忽视。我曾经测试过,一部中端手机实时编码1080p视频需要200-300毫秒。解码端同样需要时间,特别是当播放器软解码高码率视频时。

缓冲区设计 缓冲区是双刃剑。为了对抗网络抖动,系统需要设置缓冲区。但过大的缓冲区会让数据在里面“睡大觉”,人为增加延迟。很多系统默认配置的缓冲区都偏保守。

协议本身限制 某些协议天生就带着延迟基因。比如HLS基于切片传输,必须等待一个完整切片才能播放,这就引入了固定延迟。RTMP虽然延迟较低,但它的握手流程也需要时间。

服务器处理时间 边缘节点接收、转码、分发都需要计算资源。当服务器负载过高时,处理速度就会下降,延迟自然增加。

这些因素叠加起来,很容易就让直播延迟突破可接受的范围。特别是在跨国传输场景下,我曾经测量过一个从美国到中国的直播流,仅网络传输就增加了800毫秒延迟。

3.2 如何进行直播系统的延迟优化?

优化延迟就像给直播系统做精细的外科手术,需要精准定位问题所在。

协议层面优化 考虑使用低延迟协议组合。WebRTC能实现500毫秒以内的端到端延迟,特别适合互动场景。如果必须使用HLS,可以调整切片时长,从默认的10秒缩短到2-3秒。

QUIC协议值得关注。它基于UDP,能减少连接建立时间,在弱网环境下表现优异。我们正在测试的一个项目显示,QUIC比TCP节省了约30%的连接时间。

编码参数调优 关键帧间隔设置很讲究。太频繁会增加码率,太稀疏会影响seek操作。一般建议设置在2-4秒之间,既能控制延迟又不会过度牺牲画质。

启用B帧能提升压缩效率,但会增加编码延迟。在低延迟场景下,可以考虑禁用B帧,虽然码率会上升,但延迟能降低100-200毫秒。

网络传输优化 边缘节点的部署密度直接影响延迟。尽量让用户连接到地理位置上最近的节点。智能路由算法能动态选择最优路径,避开拥堵链路。

前向纠错技术能在不重传的情况下修复丢包。虽然会增加少量带宽开销,但能避免重传带来的延迟波动。

播放器优化 播放器的缓冲策略需要精心设计。我们开发过一个自适应缓冲算法,能根据网络状况动态调整缓冲区大小。网络好时缩小缓冲区降低延迟,网络差时扩大缓冲区保证流畅。

这些优化措施需要系统性地实施。单独优化某个环节效果有限,各个环节协同优化才能实现质的飞跃。

3.3 直播系统性能调优的关键指标和方法

性能调优不能凭感觉,需要建立完善的监控体系。

核心监控指标 端到端延迟是最直观的指标。要区分平均延迟和尾部延迟,后者往往更能反映用户体验。我们发现在95分位延迟控制在3秒以内时,用户基本不会抱怨卡顿。

卡顿率衡量播放流畅度。定义很关键——我们通常将连续200毫秒无法渲染新帧定义为一次卡顿。优秀的直播系统应该将卡顿率控制在1%以下。

首帧时间影响用户第一印象。从点击播放到看到第一帧的时间应该控制在800毫秒内,这个目标在现在网络环境下是完全可以实现的。

服务器性能指标 并发连接数反映系统扩展能力。单台边缘节点应该能支撑数千个并发流,这个数字会随着硬件配置和软件优化而变化。

CPU使用率需要平衡。过高会影响处理速度,过低可能意味着资源浪费。我们一般将阈值设在70%,留出应对流量波动的余量。

内存使用情况也很重要。特别是当服务器需要缓存切片时,内存不足会导致频繁的磁盘交换,严重影响性能。

调优方法论 建立基准测试环境至关重要。使用相同的测试流,在不同配置下对比性能表现。A/B测试能帮你验证优化效果。

渐进式优化比大刀阔斧改造更稳妥。先解决瓶颈最严重的环节,往往能获得最大的投入产出比。我记得有个项目只是优化了DNS解析时间,整体延迟就降低了10%。

监控数据的可视化能帮助快速定位问题。实时仪表盘应该展示关键指标的趋势变化,当某个指标异常时能立即告警。

性能调优是个持续的过程。随着用户量增长和业务需求变化,新的性能瓶颈会不断出现。保持对数据的敏感,定期回顾系统表现,才能确保直播体验始终在线。

直播技术早已超越了最初的娱乐边界,像水一样渗透到各行各业。从电商带货到在线教育,从企业培训到远程医疗,直播正在重塑我们的沟通方式。这种转变不仅仅是技术升级,更是一场关于实时连接的价值革命。

4.1 直播系统在不同场景下的应用实践

每个应用场景都有其独特的技术需求和用户体验要求。

电商直播场景 这里最看重的是互动性和转化率。我们设计的电商直播系统需要支持实时弹幕、点赞动画、商品链接即时推送。记得去年双十一,一个头部主播的直播间同时在线人数突破百万,这对系统的弹幕处理能力提出了极高要求。

礼物打赏功能在电商直播中演变成了“送礼物抵扣货款”的创新模式。这种设计巧妙地将娱乐属性转化为商业价值,用户既获得了参与感,又实际降低了购物成本。

在线教育场景 教育直播对清晰度和延迟有着双重苛求。数学公式的笔迹、化学实验的细节,都需要高分辨率保证。我们为一家在线教育机构开发的系统,特别优化了白板书写的流畅度,将笔迹延迟控制在100毫秒以内。

互动问答环节的技术实现颇具挑战。既要保证老师能实时看到学生提问,又要避免海量消息刷屏。分层显示和智能筛选成了必备功能。

企业培训场景 安全性和稳定性压倒一切。企业内部直播往往涉及商业机密,需要端到端的加密传输。我们曾为一家金融机构定制系统,采用了国密算法对视频流进行加密,连元数据都不放过。

录播回放功能在这里变得格外重要。员工可能在不同时区参与培训,异步学习的需求催生了智能剪辑功能——系统能自动识别PPT翻页时间点,生成章节导航。

远程医疗场景 这是对直播质量要求最严苛的领域。超声影像、内镜画面的传输不能有任何失真。我们参与的一个医疗项目要求视频编码必须采用无损模式,尽管这会导致带宽消耗增加数倍。

实时标注工具成为刚需。医生需要在视频画面上直接圈注病灶位置,这些标注信息必须与视频流精确同步。任何细微的延迟都可能影响诊断准确性。

4.2 直播系统开发面临的挑战与解决方案

技术发展总是伴随着新的挑战,直播领域尤其如此。

高并发场景的稳定性 百万级用户同时在线是个系统工程。单纯增加服务器数量效果有限,关键在于架构设计。我们采用边缘计算架构,将计算任务分散到各地节点,避免单点瓶颈。

去年春节红包活动期间,某个直播平台因为瞬时流量过大导致系统崩溃。事后分析发现,问题出在用户身份验证环节——所有请求都要回源校验,源站数据库根本扛不住。后来改为分布式令牌验证,问题迎刃而解。

弱网环境下的体验保障 移动网络天生不稳定。在地铁、电梯这些信号盲区,如何保持直播流畅是个难题。我们开发的多码率自适应方案能根据实时网速切换清晰度,就像给视频流装上了智能变速器。

前向纠错技术在弱网环境下大放异彩。通过在数据包中加入冗余信息,接收端能在不重传的情况下修复部分丢包。虽然增加了10%-20%的带宽开销,但换来的流畅体验值得付出这个代价。

内容安全与合规性 AI鉴黄只是内容安全的第一步。现在面临的挑战更加复杂——违规商品展示、不当言论识别都需要专门算法。我们训练的一个模型能实时检测近百种违规场景,准确率超过95%。

数字水印技术帮助解决版权纠纷。每个分发出去的视频流都嵌入了不可见的身份信息,既能追踪泄露源头,又不影响观看体验。

多平台兼容性 不同终端、不同浏览器的支持程度千差万别。特别是在苹果设备和安卓设备之间,视频解码能力存在明显差异。我们维护了一个兼容性矩阵,针对每个主流平台都有专门的优化策略。

微信小程序内的直播体验优化是个典型例子。由于微信环境的特殊性,很多标准方案都需要定制化改造。我们通过预加载和缓存策略,将小程序的首屏时间缩短了40%。

4.3 直播系统开发的未来发展趋势

技术演进的方向总是出人意料,但又合乎逻辑。

低代码开发平台的兴起 直播系统开发正在从专家技能向普惠工具转变。我们最近推出的可视化配置后台,让运营人员也能快速搭建定制化直播间。拖拽式界面设计、一键部署功能,大大降低了技术门槛。

有个客户原本需要两周才能上线的企业直播系统,现在两天就能完成配置。这种效率提升背后是组件化思维的胜利——将复杂功能封装成标准模块,按需组合使用。

AI技术的深度融合 内容理解能力将成为下一代直播系统的核心竞争力。自动生成字幕只是开始,实时语音翻译、智能内容摘要这些功能正在从概念走向实用。

我体验过一个测试版本,能在直播过程中自动识别关键内容点,并生成精彩片段集锦。这种能力对教育、培训类直播价值巨大。

沉浸式体验演进 VR直播虽然还没成为主流,但技术储备不能落后。我们正在试验的8K+180度VR直播,需要解决从采集到传输的完整技术链。光是一个视角的码率就超过百兆,传统编码技术根本无力应对。

点云直播可能是个更现实的路径。将物体转化为数百万个空间点,只传输变化部分的数据,能大幅降低带宽需求。这个思路在工业检测、远程维修场景特别有用。

边缘智能的普及 与其把所有数据都传到云端处理,不如在离用户更近的地方完成计算。智能边缘节点能实时分析视频内容,执行初步的审核、标注任务。

我们部署在CDN节点上的AI模型,已经能过滤掉80%的违规内容,大大减轻了云端压力。这种分布式智能架构,可能是应对数据爆炸的最佳答案。

隐私计算技术的应用 如何在保护用户隐私的前提下提供个性化服务?联邦学习给出了新思路。模型训练在本地完成,只上传参数更新,原始数据永远不出设备。

直播推荐系统正在尝试这个方案。既能为用户推荐感兴趣的内容,又不用担心隐私泄露问题。这种平衡艺术,或许就是技术发展的终极追求。

直播技术的未来不会局限于更好的画质、更低的延迟。它正在与各行各业深度融合,催生全新的应用形态。那些能够敏锐捕捉这些变化,并快速响应的开发者,将在下一轮竞争中占据先机。

兰州网站制作公司_企业官网建设_响应式网站_小程序开发 - 陇网工坊版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!